公司新闻

Company news

很多站长朋友都会接触robots协议文件,但是对于很多新手站长来说都是处于懵逼的状态,那么什么是robots协议文件呢?这个文件的格式和写法又是怎样的呢?如何创建robots文件呢?等这一系列的问题肯定一直困扰着大家。

今天重庆网站建设服务商追天广告传媒有限公司就来给大家分享一下网站Robots协议的写法规则。

1、什么是robots协议

它是我们的网站与各搜索引擎的一个协议,只是一个协议,搜索引擎不一定会遵守。搜索引擎蜘蛛访问我们的网站时,第一个查看的文件就是我们网站根目录下的一个命名为robots.txt的文件。robots协议不是今天写了,搜索引擎今天就会遵守,以百度为例其生效时间,需要两个月后才会遵守这个协议;

2、robots协议的作用:

(1)保护隐私。例如有些页面信息不想被外界看到,但搜索引擎又不知道哪些是隐私信息,它还是会照常抓取、展现。如果我们通过设置robots做了限制,搜索引擎蜘蛛就会放弃抓取,外界就不能通过搜索引擎了解到这些隐秘信息。

(2)调节页面抓取量。我们都知道每个网站蜘蛛抓取的配额都是有限的,如果我们通过robots.txt文件禁止一些不重要的页面被抓取,那么就节约了配额,让那些重要的页面得到更多的抓取机会。

3、robots.txt文件编写规则

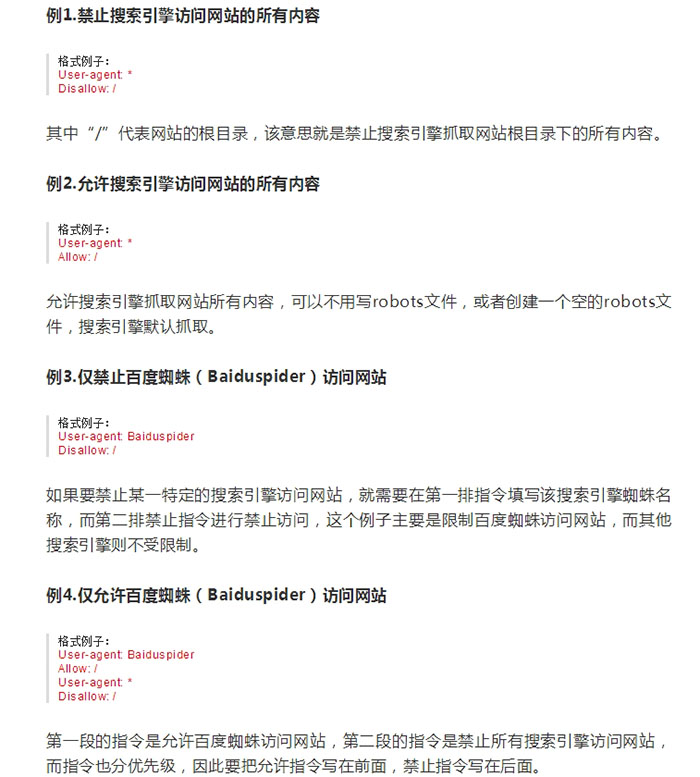

User-agent: *:这里的“*”代表的所有的搜索引擎种类,“*”是一个通配符,也可以是具体的搜索引擎蜘蛛,如Baiduspider 百度蜘蛛。

Allow:是代表允许指令,就算不写指令,搜索引擎也是默认抓取,因此允许指令的作用没其他指令大。

Disallow:该指令代表禁止指令,按网站路径或者某一特性进行限制抓取,一般后面会加上禁止访问页面的路径,作用很大。

详解可以看一下图片内容:

4、如何创建robots.txt文件?

(1)如果网站根目录下没有robots文件,可以新建一个txt纯文本文件,然后命名为“robots.txt”,然后在该文本中编辑相应指令,通过ftp上传到网站根目录即可。

(2)如果网站本身就有robots文件,则可以下载文件进行修改,然后在上传覆盖即可。注意,robots文件一定要放在根目录下。

以上就是重庆网站建设小编为大家整理的关于网站robots.txt协议的写法一些规则,希望在能帮到你。

上一篇:企业网站建设上有必要添加二维码吗

下一篇:在企业网站建设中如何做好页面布局